Sztuczna inteligencja (SI) odgrywa obecnie kluczową rolę w kształtowaniu współczesnego świata. W ciągu ostatnich kilku dekad SI przekształciła się z teoretycznego pojęcia w rzeczywistość, która zrewolucjonizowała różne dziedziny życia, od medycyny po przemysł rozrywkowy. Aby zrozumieć, jak do tego doszło, warto przyjrzeć się historii sztucznej inteligencji, która obfituje w znaczące wydarzenia, przełomy i wyzwania. Od pierwszych prób stworzenia maszyn myślących, przez złote lata rozwoju SI, po okresy kryzysu i renesansu – historia SI to opowieść o ludzkiej ambicji i nieustannym dążeniu do stworzenia technologii, która potrafiłaby myśleć i działać na poziomie zbliżonym do człowieka.

Ustalenie definicji sztucznej inteligencji

Sztuczna inteligencja (SI) to termin, który od momentu swojego powstania w latach 50. XX wieku, przeszedł wiele interpretacji i definicji. Na najbardziej podstawowym poziomie, SI można zdefiniować jako zdolność maszyn do wykonywania zadań, które normalnie wymagałyby ludzkiej inteligencji. Takich jak uczenie się, rozumowanie, rozpoznawanie wzorców, rozumienie języka naturalnego, a nawet podejmowanie decyzji. Jednak definicja sztucznej inteligencji nie jest jednoznaczna i zależy od kontekstu oraz perspektywy badawczej. W środowiskach akademickich i badawczych SI często jest definiowana przez swoje cele i funkcje. Takie jak automatyzacja procesów decyzyjnych czy symulacja ludzkiego umysłu. Inni z kolei skupiają się na technologiach, które umożliwiają rozwój SI, jak algorytmy uczenia maszynowego czy sieci neuronowe. W miarę jak technologia się rozwija, definicja sztucznej inteligencji ewoluuje, stając się coraz bardziej złożona i wieloaspektowa. Odzwierciedlając rosnące możliwości i zastosowania tej dynamicznej dziedziny.

Początki koncepcji sztucznej inteligencji

Koncepcja sztucznej inteligencji sięga daleko w przeszłość, do czasów, gdy ludzie zaczęli zadawać pytania o to, czy maszyny mogą myśleć. Jednym z pionierów w tej dziedzinie był Alan Turing, brytyjski matematyk, który w latach 50. XX wieku zaproponował tzw. test Turinga. Test ten, opisany po raz pierwszy w artykule „Computing Machinery and Intelligence” z 1950 roku. Miał na celu odpowiedzenie na pytanie: „Czy maszyny mogą myśleć?”. Aby to sprawdzić, Turing zaproponował eksperyment, w którym człowiek (sędzia) prowadziłby rozmowę zarówno z innym człowiekiem, jak i z maszyną, nie wiedząc, kto jest kim. Jeśli sędzia nie byłby w stanie z wystarczającą pewnością odróżnić maszyny od człowieka na podstawie samej rozmowy, oznaczałoby to, że maszyna przeszła test Turinga i można ją uznać za „inteligentną”.

Turing w swoim podejściu unikał dyskusji na temat definicji „myślenia”, zamiast tego skupiając się na zewnętrznych przejawach inteligencji, które można ocenić obiektywnie. Jego koncepcja była przełomowa, ponieważ odsunęła na bok filozoficzne rozważania o świadomości maszyn. Koncentrując się na praktycznych i mierzalnych aspektach inteligencji. Choć w tamtych czasach koncepcja ta była jedynie teoretyczna. Stanowiła fundament dla późniejszych badań i rozwoju SI, inspirując kolejne pokolenia naukowców do tworzenia maszyn, które potrafiłyby naśladować ludzkie zachowanie i myślenie. Test Turinga, mimo że często krytykowany za swoje uproszczenia. Pozostaje jednym z najważniejszych punktów odniesienia w dyskusjach na temat natury sztucznej inteligencji.

Warto również wspomnieć o wcześniejszych teoretykach, którzy zastanawiali się nad możliwością stworzenia „maszyn myślących”. Na przykład w XIX wieku Ada Lovelace, uważana za pierwszą programistkę komputerową. Spekulowała na temat możliwości maszyn w kontekście matematyki, co położyło podwaliny pod przyszłe koncepcje AI. Choć te pierwsze próby były bardziej filozoficzne niż techniczne. To jednak stanowiły istotny krok w kierunku zrozumienia, co to znaczy, że maszyna może „myśleć”.

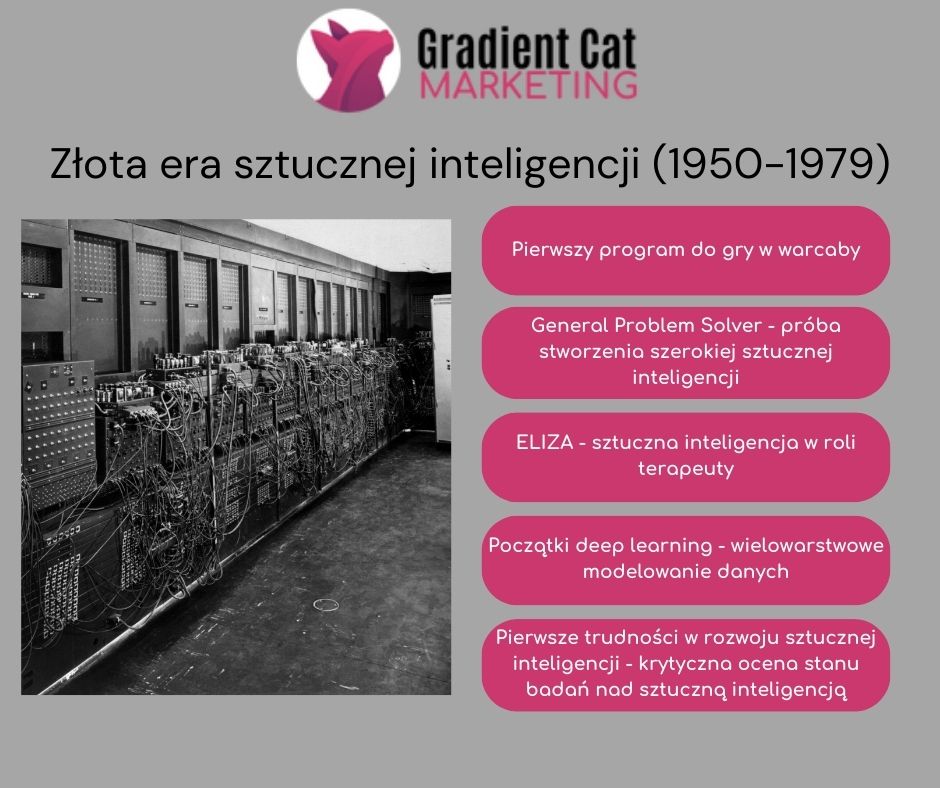

Złota era sztucznej inteligencji (1950-1979)

Okres od lat 50. do 70. XX wieku nazywany jest złotą erą sztucznej inteligencji. To czas intensywnych badań, które doprowadziły do powstania pierwszych algorytmów oraz systemów eksperckich. W 1956 roku na konferencji w Dartmouth Marvin Minsky, John McCarthy oraz Claude Shannon przedstawili idee, które stały się fundamentem dla dalszego rozwoju sztucznej inteligencji. To tam po raz pierwszy użyto terminu „sztuczna inteligencja”, co formalnie zapoczątkowało erę badań nad AI.

Pierwszy program do gry w warcaby

W 1952 roku informatyk Arthur Samuel dokonał przełomowego osiągnięcia w dziedzinie sztucznej inteligencji, tworząc program komputerowy do gry w warcaby. Był to pierwszy program, który nie tylko wykonywał zaprogramowane ruchy. Ale także uczył się samodzielnie, doskonaląc swoje umiejętności w grze na podstawie zdobytych doświadczeń. Program Samuela korzystał z technik uczenia maszynowego, co pozwoliło mu na analizowanie poprzednich rozgrywek i optymalizowanie strategii gry. To innowacyjne podejście do sztucznej inteligencji stało się fundamentem dla późniejszych badań nad uczeniem się maszyn i pokazało, że komputery mogą rozwijać swoje zdolności w sposób analogiczny do ludzkiego uczenia się.

General Problem Solver – próba stworzenia szerokiej sztucznej inteligencji

W tym okresie powstały również pierwsze programy komputerowe, które próbowały naśladować procesy myślowe. Jednym z takich przykładów jest program General Problem Solver (GPS), stworzony przez Allena Newella i Herberta Simona w 1955 roku, który potrafił rozwiązywać problemy logiczne poprzez dzielenie ich na mniejsze, znacznie lepiej zarządzalne “podproblemy”. Najważniejszą cechą tego problemu była jego zdolność do uogólniania.

ELIZA: sztuczna inteligencja w roli terapeuty

Joseph Weizenbaum, niemiecko-amerykański informatyk, w 1966 roku stworzył program komputerowy o nazwie ELIZA, który stał się jednym z najbardziej znanych przykładów wczesnej sztucznej inteligencji. ELIZA symulowała rozmowę z psychoterapeutą, korzystając z prostych skryptów do przetwarzania i odpowiadania na pytania oraz komentarze użytkownika. Program analizował wprowadzone przez użytkownika teksty, identyfikował słowa kluczowe i na ich podstawie generował odpowiedzi, które przypominały te, jakie mógłby udzielić psychoterapeuta w ramach tzw. terapii rogeriańskiej (gdzie terapeuta odzwierciedla uczucia pacjenta bez oceniania).

Chociaż ELIZA działała na dość prymitywnym poziomie, często zaskakiwała użytkowników, tworząc iluzję prawdziwego dialogu. Program ten pokazał, że komputery mogą imitować pewne aspekty ludzkiego zachowania. Takie jak reagowanie na emocjonalne wypowiedzi, co z kolei podkreśliło potencjał sztucznej inteligencji w symulowaniu interakcji międzyludzkich. Jednocześnie ELIZA zwróciła uwagę na ograniczenia ówczesnej technologii, ponieważ mimo pozornie inteligentnych odpowiedzi. Program nie rozumiał rzeczywistej treści ani kontekstu rozmowy. Dzieło Weizenbauma wywołało także istotną debatę na temat granic interakcji między człowiekiem a maszyną oraz etycznych implikacji stosowania SI w dziedzinach wymagających empatii i zrozumienia.

Początki deep learning

W 1968 roku radziecki matematyk Alexey Ivakhnenko opublikował przełomowy artykuł zatytułowany „Group Method of Data Handling” w czasopiśmie „Avtomatika”. W swoim artykule Ivakhnenko zaproponował nowatorskie podejście do sztucznej inteligencji. Polegające na wielowarstwowym modelowaniu danych, które później stało się podstawą tego, co dzisiaj znamy jako „głębokie uczenie” (deep learning). Jego metoda, oparta na automatycznym wyborze i optymalizacji modeli. Była jednym z pierwszych przykładów sieci neuronowych z wieloma warstwami, co umożliwiło bardziej złożoną analizę danych i predykcje.

Pierwsze trudności w rozwoju sztucznej inteligencji

Z kolei w 1973 roku matematyk stosowany, James Lighthill, przedstawił raport Brytyjskiej Radzie Naukowej, w którym krytycznie ocenił stan badań nad sztuczną inteligencją. Lighthill zwrócił uwagę na to, że postępy w tej dziedzinie były znacznie mniej imponujące niż obiecywali naukowcy. Co wzbudziło sceptycyzm wobec dalszego inwestowania w AI. Jego raport doprowadził do znacznego zmniejszenia wsparcia i finansowania badań nad sztuczną inteligencją przez brytyjski rząd, co przyczyniło się do tzw. „zimy AI” – okresu spowolnienia rozwoju i zmniejszonego zainteresowania badaniami nad AI w latach 70. i 80. XX wieku.

Mimo dużych postępów, naukowcy napotkali również liczne wyzwania. Ograniczenia technologiczne tamtych czasów, zwłaszcza w zakresie mocy obliczeniowej komputerów, zahamowały dalszy rozwój AI. Mimo to złota era była czasem, w którym zbudowano solidne podstawy dla przyszłych badań.

Zima sztucznej inteligencji (1970-1990)

Po okresie entuzjazmu nastąpiła tzw. zima sztucznej inteligencji – czas, w którym rozwój SI znacząco zwolnił, a zainteresowanie badaniami w tej dziedzinie osłabło. Lata 80. i 90. XX wieku były okresem, w którym wielkie nadzieje na szybkie postępy w AI zaczęły gasnąć z powodu braku oczekiwanych rezultatów. Wielu badaczy i inwestorów zaczęło tracić wiarę w możliwość stworzenia inteligentnych maszyn, co doprowadziło do znacznego ograniczenia funduszy na badania.

Głównymi przyczynami tego spowolnienia były nadmiernie ambitne obietnice oraz problemy techniczne. Wiele projektów AI, które miały przynieść rewolucję, nie spełniało oczekiwań. Na przykład systemy eksperckie, które miały zastąpić ludzkich specjalistów w podejmowaniu decyzji. Okazały się zbyt ograniczone i niepraktyczne w zastosowaniach komercyjnych. W efekcie rządy i przedsiębiorstwa ograniczyły finansowanie, a AI stała się mniej popularnym kierunkiem badań.

Załamanie rynku

W 1987 roku doszło do załamania rynku sprzętu specjalizującego się w obsłudze języka programowania LISP, który był szeroko stosowany w badaniach nad sztuczną inteligencją. Przyczyną tego upadku była rosnąca dostępność tańszych i bardziej uniwersalnych komputerów. Takich jak te produkowane przez IBM i Apple, które mogły równie skutecznie uruchamiać oprogramowanie napisane w LISP. W efekcie, firmy produkujące drogie, dedykowane maszyny LISP, takie jak Symbolics i Lisp Machines Inc. Nie były w stanie konkurować na rynku, co doprowadziło do ich upadku i ograniczenia dalszego rozwoju specjalistycznego sprzętu do AI.

Jednak mimo trudności, niektóre projekty przetrwały zimę AI, a niektóre nawet przyniosły ważne przełomy. W 1988 roku programista Rollo Carpenter stworzył chatbota o nazwie Jabberwacky, który zaprojektowany został z myślą o prowadzeniu interesujących i zabawnych rozmów z użytkownikami. Jabberwacky wyróżniał się na tle wcześniejszych chatbotów dzięki zdolności do prowadzenia bardziej naturalnych i dynamicznych interakcji. Co miało na celu symulowanie rozmowy z żywym człowiekiem. Projekt ten, będący jednym z pionierów w dziedzinie chatbotów, wyznaczył kierunek dla przyszłych rozwiązań w zakresie sztucznej inteligencji konwersacyjnej. Z czasem prowadząc do rozwoju zaawansowanych systemów interakcji człowiek-komputer.

Rozwój technologii uczenia maszynowego w latach 80. położył podwaliny pod przyszły renesans SI. Dzięki temu możliwe było późniejsze odkrycie potencjału sieci neuronowych, które stały się jednym z filarów współczesnej sztucznej inteligencji.

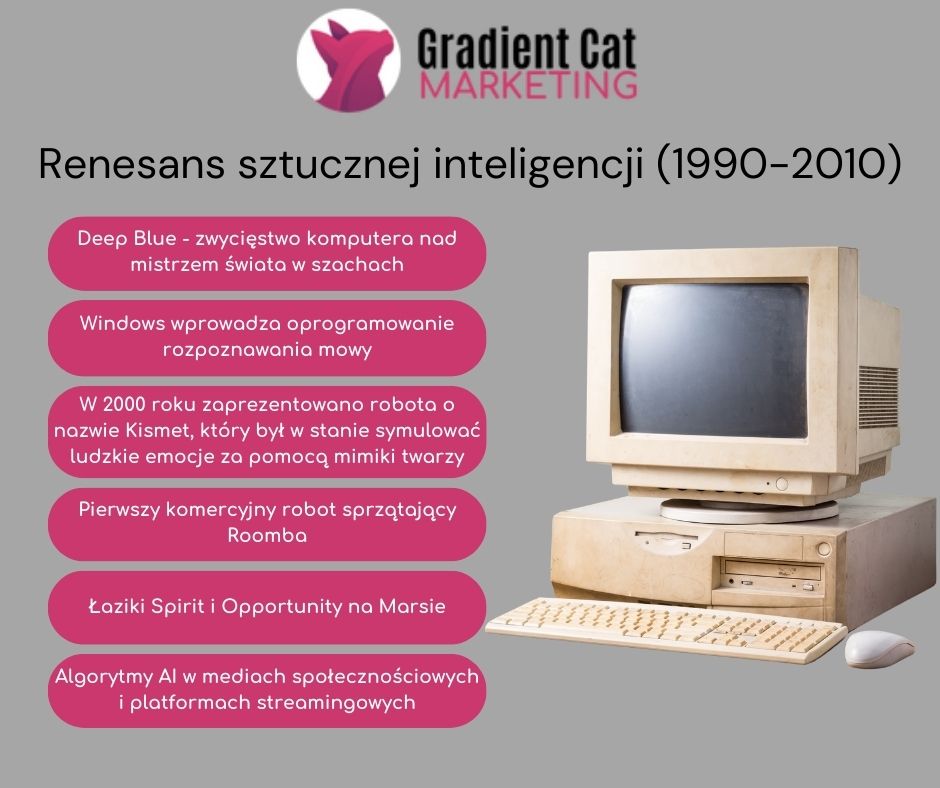

Renesans sztucznej inteligencji (1990-2010)

Lata 90. XX wieku przyniosły odrodzenie zainteresowania sztuczną inteligencją, dzięki postępom w technologii, mocy obliczeniowej komputerów i pojawieniu się nowatorskich algorytmów. W szczególności rozwój sieci neuronowych oraz technik uczenia maszynowego przyczynił się do nowej fali innowacji w dziedzinie AI.

W tym okresie zaczęły się również pojawiać coraz większe zbiory danych (big data), co umożliwiło rozwój bardziej zaawansowanych algorytmów. Dzięki big data, AI zyskało nowe możliwości analizy i interpretacji danych na niespotykaną wcześniej skalę. Rozwój technologii komputerowych, zwłaszcza w zakresie przetwarzania równoległego, pozwolił na stworzenie bardziej zaawansowanych modeli SI, zdolnych do rozwiązywania skomplikowanych problemów.

Deep Blue – zwycięstwo komputera nad mistrzem świata w szachach

W 1997 roku komputer szachowy Deep Blue, opracowany przez IBM, dokonał historycznego przełomu, pokonując mistrza świata w szachach, Garry’ego Kasparova. Mecz ten, transmitowany na cały świat, stał się symbolem przełomu w sztucznej inteligencji. Pokazało to, że komputery mogą osiągnąć poziom rozumowania i strategii, który wcześniej był uważany za domenę wyłącznie ludzką.

To wydarzenie znacząco zwiększyło zainteresowanie możliwościami SI, podkreślając jej potencjał w rozwiązywaniu złożonych problemów i przełamując bariery w postrzeganiu komputerów jako narzędzi analitycznych na poziomie eksperckim. Sukces Deep Blue zainspirował dalsze badania w dziedzinie sztucznej inteligencji, zwłaszcza w zakresie algorytmów i mocy obliczeniowej.

Windows wprowadza oprogramowanie rozpoznawania mowy

W tym samym roku, Windows przy współpracy z Dragon Systems, wprowadził oprogramowanie do rozpoznawania mowy, które zrewolucjonizowało interakcję człowieka z komputerem. Ta technologia umożliwiła użytkownikom wprowadzanie tekstu za pomocą głosu. Co otworzyło nowe możliwości dla osób z ograniczeniami ruchowymi i ułatwiło im korzystanie z komputerów na co dzień. Wprowadzenie rozpoznawania mowy do masowego użytku było kluczowym krokiem w kierunku bardziej naturalnej interakcji człowiek-maszyna, a także zapoczątkowało rozwój technologii przetwarzania języka naturalnego, które stały się fundamentem współczesnych asystentów głosowych.

Kismet: robot o ludzkich emocjach

W 2000 roku profesor Cynthia Breazeal z MIT zaprezentowała robota o nazwie Kismet, który był w stanie symulować ludzkie emocje za pomocą mimiki twarzy. Kismet potrafił poruszać oczami, brwiami, uszami i ustami, aby naśladować ludzkie reakcje emocjonalne, co stanowiło przełom w interakcji robot-człowiek. To osiągnięcie podkreśliło potencjał sztucznej inteligencji w rozumieniu i reagowaniu na ludzkie emocje. Otwierając drzwi do bardziej naturalnych i empatycznych form komunikacji z robotami. Kismet był jednym z pierwszych robotów, które wprowadziły ideę emocjonalnej interakcji, co wpłynęło na rozwój robotyki społecznej i interaktywnych systemów AI.

Pierwszy komercyjny robot sprzątający Roomba

W 2002 roku firma iRobot wprowadziła na rynek Roombę, pierwszego komercyjnego robota sprzątającego, który samodzielnie poruszał się po domu i odkurzał podłogi. Roomba stała się jednym z pierwszych przykładów praktycznego zastosowania sztucznej inteligencji w codziennym życiu. Pokazując, że roboty mogą wykonywać rutynowe zadania domowe bez konieczności nadzoru przez człowieka. Sukces Roomby zainspirował dalsze innowacje w dziedzinie automatyzacji i robotyki domowej, czyniąc inteligentne urządzenia bardziej dostępnymi dla konsumentów na całym świecie.

Łaziki Spirit i Opportunity na Marsie

W 2003 roku NASA wysłała na Marsa dwa łaziki, Spirit i Opportunity, które były wyposażone w zaawansowane systemy sztucznej inteligencji umożliwiające autonomiczne poruszanie się po powierzchni planety. Łaziki te były w stanie podejmować decyzje w czasie rzeczywistym. Omijając przeszkody i wybierając optymalne trasy, co było kluczowe dla powodzenia misji w tak odległym i trudnym środowisku.

To wydarzenie podkreśliło zdolność sztucznej inteligencji do działania w ekstremalnych warunkach i jej potencjał w eksploracji kosmosu, otwierając nowe możliwości dla badań międzyplanetarnych.

Algorytmy AI w mediach społecznościowych i platformach streamingowych

W 2006 roku firmy takie jak Twitter, Facebook i Netflix zaczęły wykorzystywać sztuczną inteligencję w swoich algorytmach reklamowych oraz doświadczeniu użytkownika (UX). Dzięki AI te platformy były w stanie analizować ogromne ilości danych użytkowników, przewidywać ich zainteresowania i dostosowywać treści. Co znacznie zwiększyło efektywność marketingu i personalizacji usług.

Wprowadzenie algorytmów AI do mediów społecznościowych i platform streamingowych zrewolucjonizowało sposób, w jaki konsumujemy treści. Jednocześnie stawiając nowe wyzwania w zakresie prywatności i etyki danych.

Współczesne zastosowania i przyszłość sztucznej inteligencji (2010-obecnie)

Od 2010 roku sztuczna inteligencja przeżywa dynamiczny rozwój, znajdując zastosowanie w coraz to nowszych dziedzinach życia. Obecnie AI jest wykorzystywane w medycynie, gdzie pomaga w diagnozowaniu chorób, w transporcie, gdzie odpowiada za rozwój autonomicznych pojazdów, a także w przemyśle, gdzie automatyzuje procesy produkcyjne i zarządzanie zasobami.

Microsoft Kinect dla Xbox 360

W 2010 roku Microsoft wprowadził na rynek Xbox 360 Kinect, pierwszy sprzęt do gier, który umożliwiał śledzenie ruchów ciała gracza i przekształcanie ich na polecenia w grach. Kinect wykorzystał zaawansowane algorytmy przetwarzania obrazu i rozpoznawania ruchu, co pozwoliło na interakcję z grami bez konieczności używania tradycyjnych kontrolerów.

To innowacyjne podejście do interakcji z technologią miało szerokie zastosowanie nie tylko w grach, ale również w innych dziedzinach, takich jak rehabilitacja, edukacja i rozrywka, inspirując dalszy rozwój technologii interfejsów użytkownika.

Watson wygrywa w Jeopardy przeciwko mistrzom

W 2011 roku komputer Watson, stworzony przez IBM, zaskoczył świat wygrywając telewizyjną grę Jeopardy! przeciwko dwóm byłym mistrzom. Watson korzystając z zaawansowanych algorytmów przetwarzania języka naturalnego (NLP) i analizy danych. Potrafił zrozumieć pytania zadawane w języku naturalnym, przeszukiwać ogromne bazy danych w ułamkach sekundy i generować trafne odpowiedzi. \

To osiągnięcie pokazało, że sztuczna inteligencja może z powodzeniem rywalizować z ludźmi w złożonych zadaniach wymagających analizy języka i wiedzy ogólnej. Co zainspirowało dalsze prace nad zastosowaniami AI w biznesie, medycynie i innych dziedzinach.

Wprowadzenie Siri przez Apple

W 2011 roku Apple wprowadził na rynek Siri, pierwszego popularnego asystenta wirtualnego, który zrewolucjonizował sposób, w jaki ludzie korzystają ze swoich urządzeń mobilnych. Siri, działająca na podstawie technologii przetwarzania języka naturalnego i rozpoznawania mowy. Umożliwiła użytkownikom interakcję z ich smartfonami za pomocą głosu, wykonując zadania takie jak wysyłanie wiadomości, ustawianie przypomnień czy przeszukiwanie internetu. Wprowadzenie Siri zapoczątkowało erę wirtualnych asystentów, które stały się integralną częścią nowoczesnych urządzeń i wpłynęły na rozwój AI w zakresie interakcji głosowej, przetwarzania języka i personalizacji usług.

Jednak z rozwojem sztucznej inteligencji wiążą się również liczne wyzwania. Wśród nich znajdują się kwestie etyczne związane z prywatnością danych, wpływem AI na rynek pracy. A także ryzykiem, jakie może stanowić rozwój autonomicznych systemów. Eksperci prognozują, że w przyszłości sztuczna inteligencja będzie odgrywać coraz większą rolę w naszym życiu. Jednak konieczne będzie znalezienie równowagi między jej możliwościami a potencjalnymi zagrożeniami.

Wnioski i refleksje na temat rozwoju sztucznej inteligencji

Historia sztucznej inteligencji to historia nieustannego rozwoju, pełna sukcesów i porażek, które ukształtowały współczesną technologię. Od pierwszych teoretycznych koncepcji maszyn myślących, przez złote lata badań, aż po współczesne zastosowania – SI przeszła długą drogę, wpływając na wiele aspektów naszego życia.

Współczesne osiągnięcia w dziedzinie AI wskazują, że przyszłość sztucznej inteligencji jest pełna możliwości, ale jednocześnie wymaga rozwagi i odpowiedzialnego podejścia. Rozwój technologii otwiera nowe horyzonty. Ale także stawia przed nami wyzwania, które będą wymagały mądrości i etycznego podejścia do ich rozwiązywania. Jak pokazuje historia, AI jest narzędziem o ogromnym potencjale, które może przynieść zarówno wielkie korzyści, jak i poważne wyzwania dla przyszłych pokoleń.

FAQ

Historia sztucznej inteligencji to bardzo obszerny temat, jednak niewątpliwie bardzo ważny. Pierwsze rozważania i badania nad sztuczną inteligencją sięgają początków XX wieku! Sprawdź, co warto wiedzieć na temat sztucznej inteligencji.

Czym jest sztuczna inteligencja?

Sztuczna inteligencja to dziedzina nauki i technologii zajmująca się tworzeniem maszyn i programów komputerowych zdolnych do wykonywania zadań, które normalnie wymagają ludzkiej inteligencji. Takich jak rozpoznawanie obrazów, podejmowanie decyzji czy rozumienie języka naturalnego.

Kto jest uważany za ojca sztucznej inteligencji?

Alan Turing, brytyjski matematyk i logik, jest uważany za jednego z ojców sztucznej inteligencji. Głównie dzięki swoim pracom nad maszynami Turinga i testem Turinga, które miały na celu określenie, czy maszyna może wykazywać inteligentne zachowanie.

Czym była „zima AI”?

„Zima AI” to okres pomiędzy latami 70. i 90. XX wieku, kiedy rozwój i zainteresowanie sztuczną inteligencją znacząco spadły z powodu niewystarczających postępów i nadmiernie ambitnych obietnic, które nie zostały spełnione.

Jakie były kluczowe wydarzenia w renesansie AI?

Jednym z kluczowych wydarzeń było zwycięstwo komputera Deep Blue nad mistrzem świata w szachach Garrym Kasparovem w 1997 roku. To wydarzenie symbolizowało znaczący postęp w dziedzinie sztucznej inteligencji i zainspirowało dalsze badania.

Jakie są współczesne zastosowania sztucznej inteligencji?

Sztuczna inteligencja znajduje szerokie zastosowanie w medycynie (diagnozowanie chorób), transporcie (autonomiczne pojazdy), przemyśle (automatyzacja). A także w codziennym życiu, np. w postaci asystentów głosowych, takich jak Siri i Alexa.

Jakie wyzwania wiążą się z rozwojem sztucznej inteligencji?

Wyzwania związane z AI obejmują kwestie etyczne. Takie jak prywatność danych, wpływ na rynek pracy, oraz potencjalne zagrożenia związane z rozwojem autonomicznych systemów. Ważne jest, aby rozwijać AI w sposób odpowiedzialny i zrównoważony.

Dodaj komentarz